- 본 게시글은 Density estimation using deep generative neural networks 정리글입니다.

- 개인적인 생각이 서술되어 있습니다. 잘못된 내용이 존재할 확률이 존재하기에 주의 바랍니다.

- 잘못된 내용, 오타는 지적해 주시면 감사하겠습니다.

Reference

Liu, Q., Xu, J., Jiang, R., & Wong, W. H. (2021). Density estimation using deep generative neural networks. Proceedings of the National Academy of Sciences, 118(15), e2101344118. / APA style

Abstract

- 밀도 추정은 통계 및 머신러닝에서 근본적인 문제

- 본 논문은 심층 생성 신경망 기반인 Roundtrip을 제안

- Roundtrip은 심층 생성 모델(ex: GAN)의 생성 능력을 유지하는 동시에 밀도 값의 추정치를 제공 → 데이터 생성과 밀도 추정 모두 지원

- 이전 신경 밀도 추정기는 잠재 공간에서 데이터 공간으로의 변환에 엄격한 조건을 적용

- Roundtrip은 기본 밀도(예: 가우시안 분포)에서 유도된 manifold를 학습, 대상 밀도를 모델링하는 더 일반적인 매핑을 사용가능

- Roundtrip은 GAN 모델에 밀도 값의 explcit 평가가 가능한 통계적 프레임워크를 제공

- Roundtrip은 다양한 밀도 추정 과제에서 SOTA를 달성

Introduction

- 히스토그램 및 커널 밀도 추정기(KDE)와 같은 전통적인 밀도 추정기는 낮은 차원에서만 잘 작동

- 최근 신경망 기반 접근 방식이 밀도 추정에서 제안, 신경 밀도 추정기에는 주로 autoregressive 모델과 normalizingflows의 두 가지 계열이 있음

autoregressive, normalizing flows 설명은 아래 게시글을 참조하면 됩니다.

https://life-ai-learning.tistory.com/36

[논문 정리] Masked Autoregressive Flow for Density Estimation

본 게시글은 Masked Autoregressive Flow for Density Estimation 정리글입니다. 개인적인 생각이 서술되어 있습니다. 잘못된 내용이 존재할 확률이 존재하기에 주의 바랍니다. 잘못된 내용, 오타는 지적해 주

life-ai-learning.tistory.com

- 앞서 설명한 모델에서의 x의 밀도 추정은 다음 두 가지 조건이 성립할 때 가능함

- 1. 쉽게 역변환 가능해야 함 / 2. 자코비안 행렬식 계산이 쉬워야 함

- 기본 밀도의 차원이 타겟 밀도와 다른 경우 change of variable rule이 적용되지 않음(차원이 동일해야 가역 변환 가능함) 그러나 심층 생성 모델(ex: GAN, VAE)에 따르면 데이터 공간보다 작은 차원의 잠재 공간을 사용하는 것이 좋음

- 언급한 한계를 극복하기 위해 Roundtrip을 제안

- Roundtrip은 두 가지 측면에서 이전의 신경 밀도 추정기와 다름

- 1. Previous: 신경망을 가역 변환에 사용되는 함수의 파라미터 학습에만 사용→ Roundtrip: 심층 생성 네트워크를 latent space에서 data space로의 변환에 사용

- 2. 잠재 공간이 데이터 공간과 동일한 차원을 가져야 하기에 달성하기 어려웠던, 학습된 manifold 근처에 집중된 데이터 밀도를 효율적으로 모델링할 수 있음

- +밀도 추정의 pointwise 평가를 위해, Importance sampling 혹은 Laplace Approximation 기반 방법도 제공함

- Roundtrip의 주요 contributions은 다음과 같음

- 1. 이전에 비해 덜 제한적인 가정을 요구하는 심층 생성 모델 기반, 범용 신경 밀도 추정기를 제안

- 2. 이전 신경 밀도 추정기의 원리가 Roundtrip의 특별한 경우로 간주될 수 있음을 보여줌

- 3. 이미지 생성 ~ 이상치 탐지에 이르는 실제 데이터 & 시뮬레이션의 밀도 추정에서 SOTA를 달성함

Methods

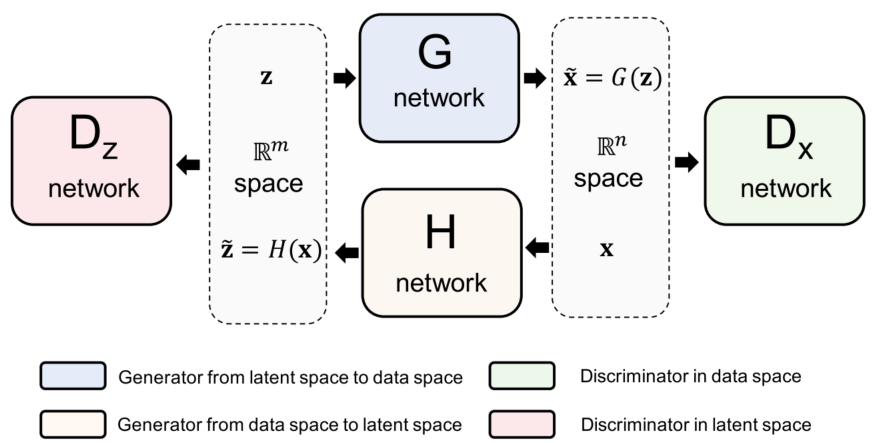

Roundtrip의 핵심 아이디어는 변환이 두 개의 GAN 모델(Fig. 1)로 표현되는 기본 분포를 변환하여 매니폴드에서 유도된 분포와, 가우시안의 컨벌루션으로 타겟 분포를 근사화하는 것입니다. 두 GAN 모델의 가중치를 학습한 후 offline 알고리즘을 통해 밀도 추정을 수행합니다.

Model for the Data Density

- z는 m차원에, x는 n 차원에 있다고 가정

- z는 알려진 밀도 p_z(z) z(ex: standard Gaussian)를 가지며, x는 i.i.d를 기반으로 추정하려는 타겟 밀도 p_x(x)에 따라 분포됨

- 본 논문은 두 분포 간의 forward 및 backward 매핑 관계를 학습하기 위해 두 개의 함수 G(·) 및 H(·)를 도입했고, 이 두 함수는 두 개의 신경망으로 학습됨(Fig. 1)

- 양방향 GAN 아키텍처는 컴퓨터 비전에서 사용된 적은 있지만, 본 논문은 밀도 추정을 위해 활용함

- 이를 위해 우리는 G(z) = x~ 및 H(x) = z~로 표시하고, forward 매핑 오류가 가우시안 분포를 따른다고 가정

- m차원 < n차원으로 설정하는데, 이는 x~가 고유 차원 m을 갖는 R**n의 다양체에서 값을 취함을 의미

- 기본적으로 Roundtrip은 G(·)를 사용하여 다양체를 생성한 다음, 혼합 밀도가 다양체의 타겟 밀도 px ~(x ~)인 가우시안 혼합으로 목표 밀도를 근사화

↓

- 밀도 추정 문제는 Equation 3을 적분하는 것으로 바뀜

- G(·)와 H(·)가 이미 학습되었다고 가정하고, Equation 3을 평가함

- 평가는 importance sampling 혹은 Laplace approximation으로 진행

Importance Sampling

Equation 3를 평가하는 가장 간단한 방법은, 평균의 법칙을 사용하는 것입니다.

그러나 위의 평균의 법칙은 매우 비효율적임

기본 밀도 p_z(z) 대신, importance 분포 q(z)에서 z_i를 샘플링하고 importance weighted estimate 사용을 제안

N: sample size, importance weight function: w(z) = p_z(z)/q(z), i.i.d smaples from q(z): {(z_i)**q}

정리:

weight가 p_z(z)와 비슷한 분포로 근사하는 느낌으로 해석

Laplace Approximation

- 베이지안 통계에서는 사후분포를 다루는데 어려움이 있음

- 사후분포가 unimodal이라면 가장 큰 확률이 mode임 → Laplace Approximation이 적절하게 사용될 수 있음

Laplace Approximation을 이해하는데 많은 도움을 준 블로그입니다

https://daljoong2.tistory.com/188

[베이지안 딥러닝] Ch4.4 Linear Models for Classification - The Laplace Approximation

2020-2학기 이화여대 김정태 교수님 강의 내용을 바탕으로 본 글을 작성하였습니다. Overview Discriminant Functions Probabilistic Generative Models Probabilistic Discriminative Models The Laplace Approximation Bayesian Logistic Re

daljoong2.tistory.com

Adversarial Training Loss

Roundtrip 모델은 두 개의 GAN 모델 쌍으로 구성됩니다. forward GAN 모델에서 네트워크 G는 관측 데이터와 유사한 샘플 x~ 생성을 목표로 합니다. 반면 판별자 D_x는 관측 데이터(양수)와 생성된 샘플(음수)을 구별하려고 시도합니다. backward GAN 모델에서 네트워크 H와 판별자 D_z는 데이터 분포를 latent space의 기본 분포에 근사하도록 변환하는 것을 목표로 합니다.

Roundtrip Loss

Full Training Loss

Experiment

Real Data

'논문 정리' 카테고리의 다른 글

| [논문 정리] Digital Twin in manufacturing: A categorical literature review and classification (0) | 2023.03.08 |

|---|---|

| Generative Model for Density Estimation 발표영상 (0) | 2023.03.03 |

| [논문 정리] Masked Autoregressive Flow for Density Estimation (0) | 2023.02.21 |

| [논문 정리] Continual Learning for Anomaly based Network Intrusion Detection (0) | 2023.02.05 |

| [논문 정리] Continual Learning with Deep Generative Replay (2) | 2023.02.04 |